>> Xavier 초기화의 정규분포 식

[도전! 연습문제]

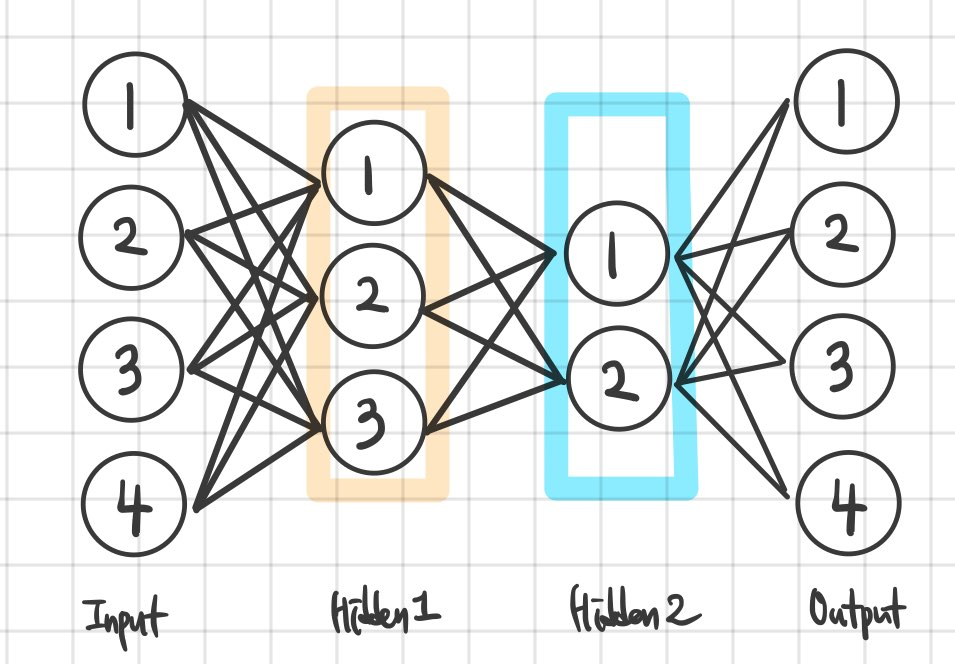

아래 그림과 같은 3층 신경망이 있다. Xavier 를 이용해 은닉층 1, 2의 가중치 값을 초기화 를 계산 해 보아라.

He

홍콩 중문대 박사과정의 Kaiming he가 이 초기화 방법을 사용해 ImageNet에서 에러율 3%를 달성하게 되며 주목을 받게 된 방식이다. 기존 Xavier 초기화에서 앞 층의 노드 수를 2로 나눈 후 루트를 씌운 방식으로 Xavier에 비해 분모가 작기 때문에 활성화 함수 값들을 더 넓게 분포 시킨다.

Xavier와 유사하지만 He는 입력 노드와 출력 노드의 개수를 모두 고려하지 않고 입력 노드 수만 고려한다는 점에서 차이가 있다.

[도전! 연습문제]

아래 그림과 같은 3층 신경망이 있다. He 를 이용해 은닉층 1, 2의 가중치 값을 초기화 를 계산 해 보아라.

작성자 홍다혜 ghdek11@gmail.com / 이원재 wonway333@gmail.com

'【1】Deep Learning 시작하기 > 다시 마주친 장벽, Vanishing Gradient Problem' 카테고리의 다른 글

| 발전된 비선형 함수(Nonlinearity) (Ricky ReLU / Parametric ReLU 등) (0) | 2020.01.14 |

|---|---|

| 해결책 2 : 문제는 활성화 함수 - ReLU / (확률분포) (0) | 2020.01.12 |

| I am Hinton! 기울기 소실 사건을 해결하다! - 제한 볼츠만 머신(RBM) (0) | 2020.01.11 |

| 핑거 스냅? 기울기가 사라진다! (0) | 2020.01.10 |