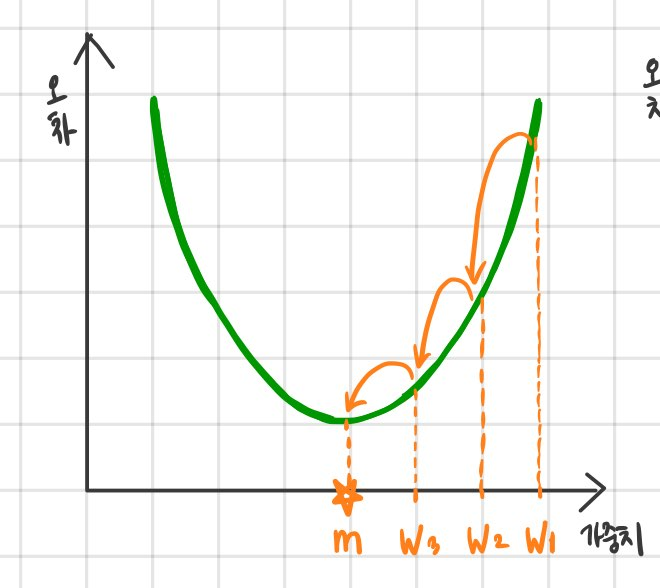

이전 글에서 설명한 바와 같이 오차가 최소가 되는 가중치 값을 찾기 위해 오차가 작아지도록 가중치를 수정해 나간다. 가중치는 너무 작아도 혹은 너무 커져도 오차가 커지므로 이러한 관계를 그래프로 표현하면 다음과 같다.

그림에서 보듯 오차를 최소로 하는 최적의 가중치 값을 m이라고 했을 때 이를 찾기 위해서는 랜덤하게 설정한 초기 가중치 값 w1을 시작으로 w1->w2->w3->m으로 이동시켜야 한다. 그렇게 하려면 초기w1보다 w2가, w2보다는 w3가 우리가 찾으려는 m에 가깝다는 것을 알아야 한다.

컴퓨터가 최적의 m값에 가까워지는지 어떻게 알 수 있을까? 바로 그래프에서 기울기를 구해 판단하는데 이러한 방법을 경사하강법이라고 한다. 경사하강법은 말 그대로 기울어진 정도인 경사가 낮아지도록 하는 방법을 말한다. 그렇다면 경사가 의미하는 바는 무엇일까? 여기서 미분의 개념이 등장한다. 수학이 등장해서 당황하지는 않았는가? 걱정마라, 우리가 필요로 하는 미분은 가벼운 정도이며 이 또한 함께 짚고 넘어갈테니 충분히 따라올 수 있을 것이다.

작성자 홍다혜 ghdek11@gmail.com / 이원재 wonway333@gmail.com

'【1】Deep Learning 시작하기 > 딥러닝이 알고 싶다!' 카테고리의 다른 글

| 경사하강법(Gradient Descent Optimizer) (0) | 2020.01.05 |

|---|---|

| 퍼셉트론 동작 (0) | 2020.01.03 |

| 퍼셉트론이 마주친 장벽 (0) | 2020.01.02 |

| 딥러닝의 뿌리를 찾아서, 퍼셉트론은 누구인가? (0) | 2020.01.01 |